Solomon Kullback, « Information Theory and Statistics »

Une référence historique

J’ai hésité à montrer mon intérêt pour ce livre. En fait, ça dépend de à quoi il peut servir. Pour moi il vaut cinq étoiles.

J’ai hésité à montrer mon intérêt pour ce livre. En fait, ça dépend de à quoi il peut servir. Pour moi il vaut cinq étoiles.

Tout d’abord, si ce que vous intéresse est le sujet du livre – Théorie de l’Information et Statistiques – que vous soyez débutant ou pas, il y a plein de livres plus récents, de lecture plus abordable et de contenu plus actuel. N’achetez pas ce livre si vous êtes dans ce cas.

L’intérêt est historique. Ce livre a été écrit dans les années 50, il y a plus de 60 ans. A l’époque, le papier séminal de C.E. Shannon sur la Théorie d’Information avait moins de 10 ans.

Kullback a été un des premiers à formaliser les liens entre la Théorie de l’Information et les Statistiques, notamment avec avec la « Divergence de Kullback-Leibler », une mesure permettant de comparer des distributions de probabilité, utilisée dans plusieurs applications en statistiques ou apprentissage artificielle.

Ce livre nous ramène à l’état de l’art de la discipline dans les années 50, avec une présentation rigoureuse et claire de sa démarche. C’est un livre très intéressant surtout pour ceux qui ont déjà une connaissance du domaine et souhaitent se plonger dans les travaux de Kullback.

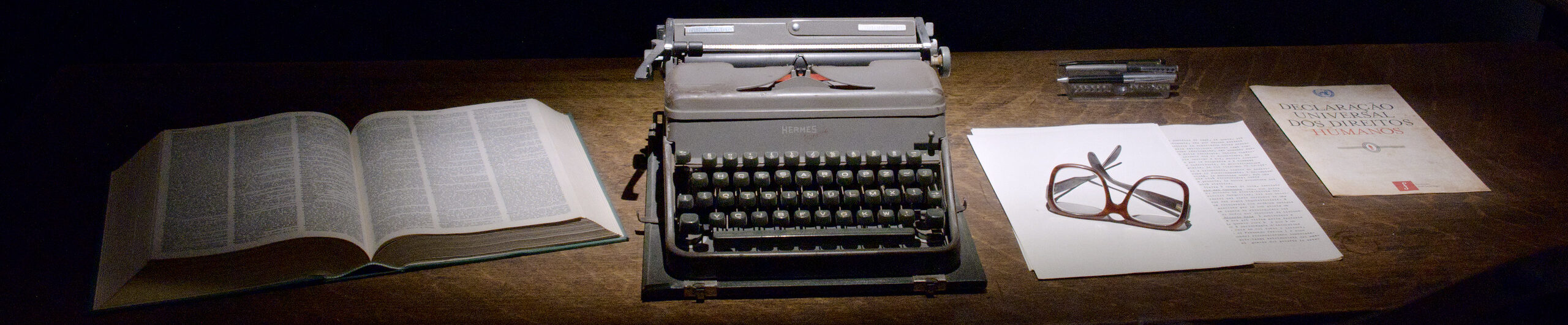

Solomon Kullback est un de ceux qui ont fait une contribution significative à la fois à la Théorie d’Information et aux Statistiques. Il n’est pas étonnant d’apprendre que, comme Shannon, Turing et autres, il a travaillé sur des problèmes de cryptanalyse pendant la deuxième guerre.

Donc, c’est surtout pour l’intérêt historique et pour l’importance de la contribution de ce livre à la discipline.